一、爬取数据

话不多说了,直接上代码( copy即可用 )

import requests

import pandas as pd

class SpiderRumor(object):

def __init__(self):

self.url = "https://vp.fact.qq.com/loadmore"

self.header = {

"User-Agent": "Mozilla/5.0 (iPhone; CPU iPhone OS 11_0 like Mac OS X) AppleWebKit/604.1.38 (KHTML, like Gecko) Version/11.0 Mobile/15A372 Safari/604.1",

}

def spider_run(self):

df_all = list()

for url in [self.url % i for i in range(30)]:

data_list = requests.get(url, headers=self.header).json()["content"]

temp_data = [[df["title"], df["date"], df["result"], df["explain"], df["tag"]] for df in data_list]

df_all.extend(temp_data)

print(temp_data[0])

pd.DataFrame(df_all, columns=["title", "date", "result", "explain", "tag"]).to_csv("冠状病毒谣言数据.csv", encoding="utf_8_sig")

if __name__ == '__main__':

spider = SpiderRumor()

spider.spider_run()

爬虫过程

二、数据分析

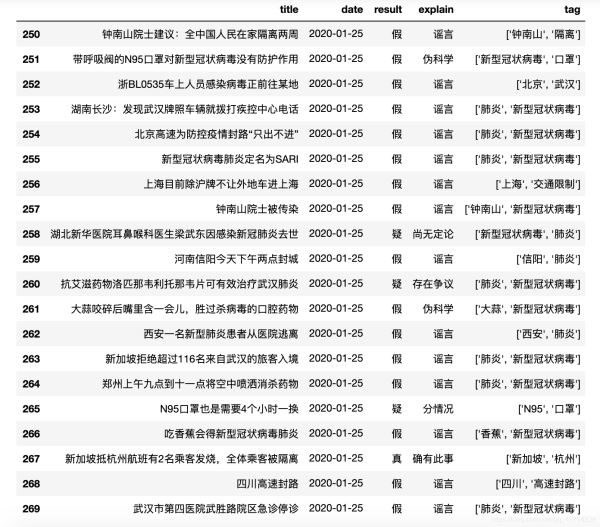

数据展示

每日谣言数量

由图可得:1月24日和1月25日是谣言的高峰期,让我们来看看这两天的数据:

由上图得知 一月二十四号和二十号传播的 29 条谣言中 96.55% 都是假的

谣言是否属实占比

从1月18日到今日截止2月14日共发现了300条谣言,右上图可得:76.33% 都是假的,只要 7.00% 是属实的,其中 14.33% 的谣言属于 伪科学 而且 还有 8.00% 属于尚无定论凭空捏造出的,需要多注意"text-align: center">

下面介绍 matplotlib 绘制饼图的代码

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

# Windows系统设置中文字体

plt.rcParams['font.sans-serif']=['SimHei']

plt.rcParams['axes.unicode_minus'] = False

data = pd.read_csv("/冠状病毒谣言数据.csv"")

labels = data["explain"].value_counts().index.tolist()

sizes = data["explain"].value_counts().values.tolist()

colors = ['lightgreen', 'gold', 'lightskyblue', 'lightcoral']

plt.figure(figsize=(15,8))

plt.pie(sizes, labels=labels,

colors=colors, autopct='%1.1f%%', shadow=True, startangle=50) # shadow=True 表示阴影

plt.axis('equal') # 使图居中

plt.show()

绘制谣言关键字分布图(观察 tag 这个字段)

由于 tag 这个字段内容是列表,我们取出来后是列表嵌套列表:[[a, b], [b, c], [c, d]] 我们要使用一行列表生成式快速的将所以的关键字取出来 [j for i in a for j in i]

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

# Windows系统设置中文字体

plt.rcParams['font.sans-serif']=['SimHei']

plt.rcParams['axes.unicode_minus'] = False

data = pd.read_csv("/冠状病毒谣言数据.csv"")

df = pd.Series([j for i in [eval(i) for i in data["tag"].tolist()] for j in i]).value_counts()[:20]

X = df.index.tolist()

y = df.values.tolist()

plt.figure(figsize=(15, 8)) # 设置画布

plt.bar(X, y, color="orange")

plt.tight_layout()

# plt.grid(axis="y")

plt.grid(ls='-.')

plt.show()

总结

以上所述是小编给大家介绍的Python爬取新型冠状病毒“谣言”新闻进行数据分析,希望对大家有所帮助!

免责声明:本站文章均来自网站采集或用户投稿,网站不提供任何软件下载或自行开发的软件!

如有用户或公司发现本站内容信息存在侵权行为,请邮件告知! 858582#qq.com

暂无“Python爬取新型冠状病毒“谣言”新闻进行数据分析”评论...

RTX 5090要首发 性能要翻倍!三星展示GDDR7显存

三星在GTC上展示了专为下一代游戏GPU设计的GDDR7内存。

首次推出的GDDR7内存模块密度为16GB,每个模块容量为2GB。其速度预设为32 Gbps(PAM3),但也可以降至28 Gbps,以提高产量和初始阶段的整体性能和成本效益。

据三星表示,GDDR7内存的能效将提高20%,同时工作电压仅为1.1V,低于标准的1.2V。通过采用更新的封装材料和优化的电路设计,使得在高速运行时的发热量降低,GDDR7的热阻比GDDR6降低了70%。

更新动态

2026年03月07日

2026年03月07日

- 小骆驼-《草原狼2(蓝光CD)》[原抓WAV+CUE]

- 群星《欢迎来到我身边 电影原声专辑》[320K/MP3][105.02MB]

- 群星《欢迎来到我身边 电影原声专辑》[FLAC/分轨][480.9MB]

- 雷婷《梦里蓝天HQⅡ》 2023头版限量编号低速原抓[WAV+CUE][463M]

- 群星《2024好听新歌42》AI调整音效【WAV分轨】

- 王思雨-《思念陪着鸿雁飞》WAV

- 王思雨《喜马拉雅HQ》头版限量编号[WAV+CUE]

- 李健《无时无刻》[WAV+CUE][590M]

- 陈奕迅《酝酿》[WAV分轨][502M]

- 卓依婷《化蝶》2CD[WAV+CUE][1.1G]

- 群星《吉他王(黑胶CD)》[WAV+CUE]

- 齐秦《穿乐(穿越)》[WAV+CUE]

- 发烧珍品《数位CD音响测试-动向效果(九)》【WAV+CUE】

- 邝美云《邝美云精装歌集》[DSF][1.6G]

- 吕方《爱一回伤一回》[WAV+CUE][454M]